AI Toolkit:一站式扩散模型微调神器

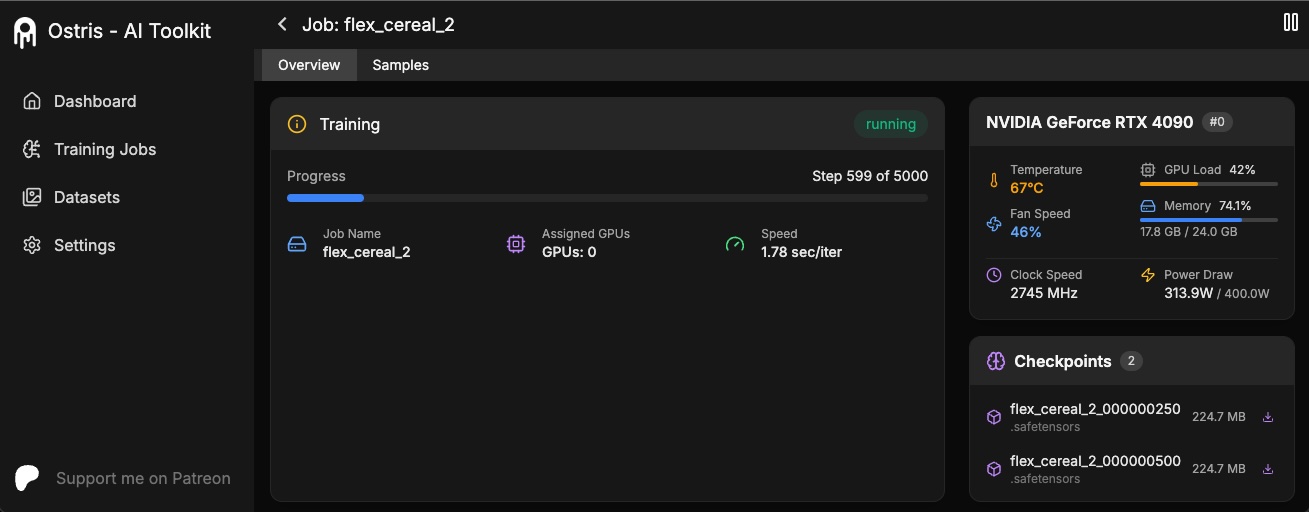

🔥 你是否曾被复杂的模型训练流程劝退?现在,Ostris团队推出的AI Toolkit彻底解决了这个痛点!这款开源工具包专为消费级显卡设计,支持图像和视频扩散模型的微调训练,只需简单配置即可快速上手,还能通过可视化界面实时监控训练过程。

🚀 核心功能

- 硬件友好

支持消费级NVIDIA显卡(最低24GB显存),通过量化技术优化显存占用,即使搭配显示器也能流畅训练。 - 双模式运行

- 命令行模式:高效执行批量任务

- Web可视化界面:实时监控训练状态、启停任务

- 全模型支持

兼容最新扩散模型架构,包括:

- FLUX.1-dev(需HuggingFace授权)

- FLUX.1-schnell(Apache 2.0开源协议)

- 视频生成模型Wan 2.1

🛠️ 三步极速上手

- 环境部署

git clone https://github.com/ostris/ai-toolkit

cd ai-toolkit

python3 -m venv venv

source venv/bin/activate

pip3 install torch==2.7.0 torchvision==0.22.0

pip3 install -r requirements.txt

- 数据集准备

- 创建

dataset文件夹 - 放入图像文件(jpg/png)和同名文本标注文件

- 示例:

image1.jpg对应image1.txt

- 启动训练

# 复制并修改配置文件

cp config/examples/train_lora_flux_24gb.yaml config/my_config.yaml

# 开始训练

python run.py config/my_config.yaml

🌐 云端训练方案

- RunPod云服务

选择A40显卡(48GB显存)配置:

GPU: 1x A40

vCPU: 19核

内存:100GB

存储:240GB

- Modal无服务器架构

通过Volume持久化存储模型:

# 设置存储卷

volume = modal.Volume.persisted("flux-lora-models")

⚙️ 高级技巧

- 定向训练特定层

在配置文件中指定关键层:

network_kwargs:

only_if_contains:

- "transformer.single_transformer_blocks.7.proj_out"

- LoKr替代训练

比传统LoRA更高效的训练方案:

network:

type: "lokr"

lokr_factor: 8

🌟 同类工具推荐

- Kohya_SS

- 特点:专注Stable Diffusion微调

- 优势:社区资源丰富,教程完善

- Diffusers

- 特点:HuggingFace官方扩散模型库

- 优势:预置SOTA模型,支持pip一键安装

- ComfyUI

- 特点:节点式可视化工作流

- 优势:适合复杂模型管道搭建

项目地址:https://github.com/ostris/ai-toolkit

训练效果展示:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容